A Google terá conseguido alcançar uma nova etapa crucial rumo à computação quântica. A tecnológica norte-americana terá solucionado uma das barreiras mais notórias que a impediam de criar um computador quântico, potenciador de sistemas exponencialmente mais poderosos.

Ainda que de momento os computadores quânticos sejam, sobretudo, um milagre teórico, certo é que a cada novo desenvolvimento estamos mais próximos de aproveitar todo o seu potencial.

Teoricamente, estas máquinas providenciarão níveis nunca vistos de computação e poder de processamento, com várias dificuldades técnicas a carecerem de solução até lá.

Computação quântica é um dos maiores desafios atuais da Humanidade

Ora, precisamente um dos grandes problemas da computação quântica é a quantidade de erros a que os qubits (o bit quântico, ou qubit é uma unidade de informação quântica) a que a computação quântica está sujeita.

Uma vez que cada qubit só consegue estar numa determinada posição (X, Y, Z) durante breves instantes, o computador tem sérias dificuldades em saber com exatidão qual a posição desse "interruptor" de informação.

Face ao exposto, a quantidade de erros gerados é multiplicada de forma exponencial à medida que aumentam as unidades de processamento, os qubits.

Atualmente, este é um dos maiores entraves à utilidade prática dos computadores quânticos que, apesar de extraordinariamente poderosos, estão aplacados por uma quantidade igualmente exponencial de erros.

Mecanismo de redução de erros representa avanço significativo da Google

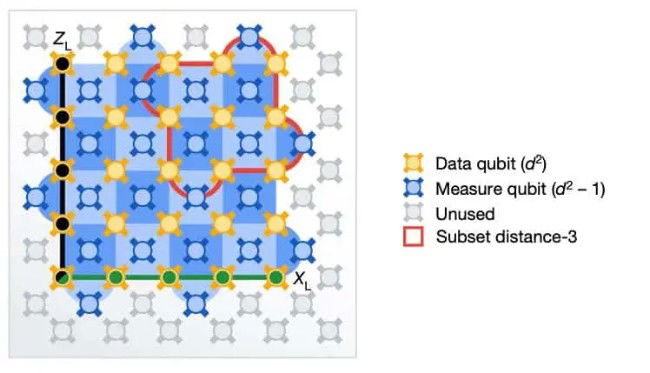

É aqui que entra o grande anúncio da Google. A tecnológica afirma ter desenvolvido uma forma eficaz para reduzir esta taxa de erros na computação quântica. Fá-lo ao distribuir um estado determinado por vários bits quânticos.

Por outro lado, a Google afirma que este desenvolvimento reduz em 4% a taxa de erros, algo que pode parecer insignificante, mas que no mundo quântico não é bem assim.

Segundo a tecnológica, esta redução de 4% nos erros parece ser um valor suficiente para possibilidade o aumento de número de qubits. Isto sem causar um aumento exponencial na taxa de erros de leitura.

Por outras palavras, permitirá a conceção e execução de sistemas com mais bits quânticos funcionais e dos quais poderemos obter uma utilidade prática e funcional.

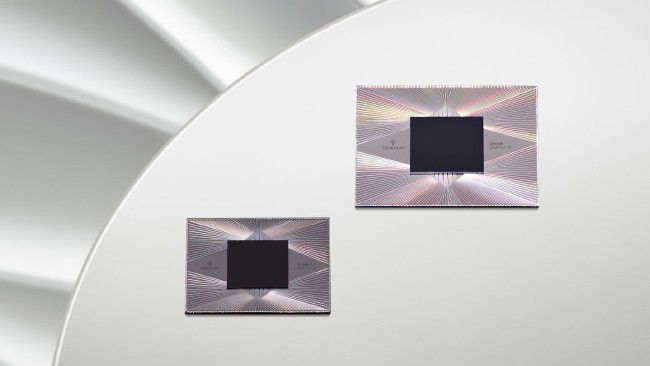

Temos um novo processador Google Sycamore

Para aplicarem esta redução de erros a Google essencialmente criou um processador de nova geração. Apelidado Sycamore, é pelo seu "músculo" que a Google operará esta redução na taxa de erros na leitura das posições dos bits quânticos.

Ainda que o novo processador e todo o sistema subjacente de otimização sejam excelentes notícias no campo da computação quântica, a Google adota uma postura mais reservada.

Com efeito, a tecnológica afirma que este é um passo importante dado nesta área, mas que ainda há um grande caminho até ser viável construir um computador quântico comercialmente viável. A descoberta é, todavia, deveras assinalável.

Por fim, podemos descrever a computação de modo despudoradamente simplista ao fazer uma comparação com a atual computação e processamento de dados.

Passamos de uma linguagem binária de 1's e 0's, descrevendo os dois estados possíveis, para uma realidade "tridimensional" com X, Y e Z. Ou seja, desbloqueando uma nova potência de possibilidades no processamento de dados. A propósito, veja-se o princípio da incerteza quântica de Heisenberg.

Editores 4gnews recomendam: